AI Act i nowe obowiązki dla podmiotów rozwijających i wykorzystujących sztuczną inteligencję

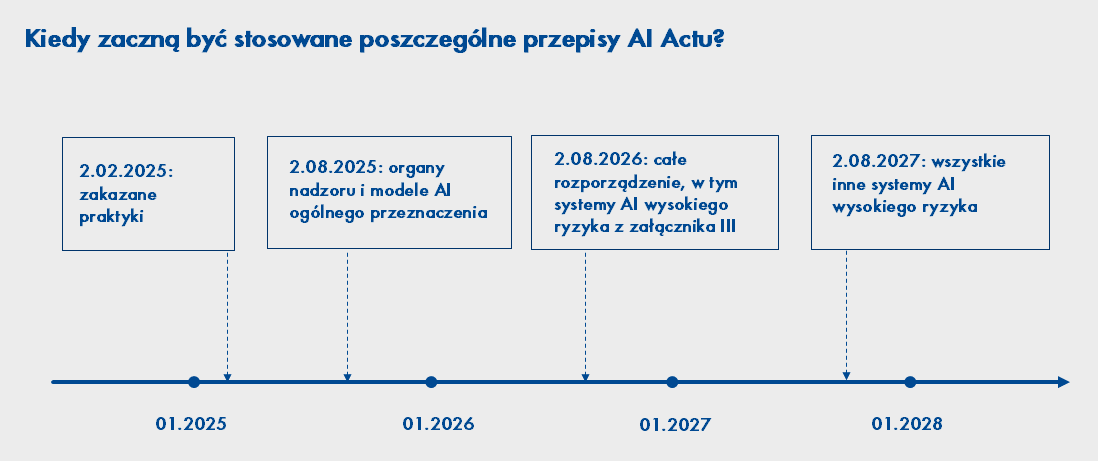

2 sierpnia 2024 r. wszedł w życie tzw. AI Act1, czyli rozporządzenie, które ma uregulować niektóre aspekty korzystania z tzw. sztucznej inteligencji. Co do zasady rozporządzenie będzie stosowane od 2 sierpnia 2026 r. Unijny ustawodawca przewidział także przepisy przejściowe, aby wszystkie podmioty, do których AI Act ma zastosowanie, mogły przystosować się do nowych obowiązków.

- 2.02.2025 r. – zaczną być stosowane przepisy dotyczące zakazanych praktyk w zakresie AI,

- 2.08.2025 r. – zaczną być stosowane przepisy dotyczące organów nadzoru oraz dotyczące modeli AI ogólnego przeznaczenia,

- 2.08.2027 r. – zaczną być stosowane przepisy dotyczące wszystkich innych systemów AI wysokiego ryzyka niż te, które zostały wymienione w załączniku III do rozporządzenia.

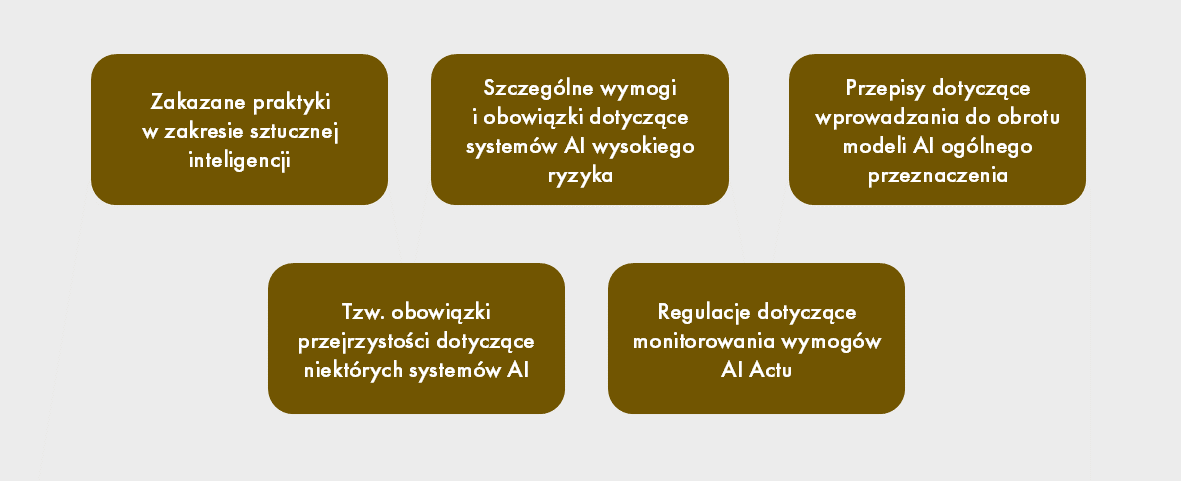

Co reguluje AI Act?

Wbrew obiegowej opinii AI Act nie reguluje wszystkich prawnych aspektów związanych

z korzystaniem z AI. Unijne rozporządzenie skupia się przede wszystkim na uregulowaniu kwestii związanych z korzystaniem z systemów, które zostały ocenione jako stwarzające wysokie ryzyko dla funkcjonowania społeczeństwa (tj. np. stosowanych w edukacji, zatrudnieniu, wykorzystujących biometrię) oraz systemów i modeli ogólnego przeznaczenia (ang. general purpose AI models), takich jak np. Chat GPT.

AI Act określa:

Jakie praktyki są zakazane i które systemy AI mogą zostać zakwalifikowane jako systemy wysokiego ryzyka?

Prawodawca unijny dostrzega wiele korzystnych zastosowań sztucznej inteligencji, które mogą poprawić jakość życia, ale widzi też wiele zagrożeń dla bezpieczeństwa, zdrowia i praw podstawowych, które mogą być skutkiem stosowania systemów AI. W AI Akcie przesądzono, że niektóre praktyki wykorzystujące systemy sztucznej inteligencji powinny być zakazane z uwagi na ich sprzeczność z unijnymi wartościami.

W katalogu praktyk zakazanych znalazły się m.in. praktyki polegające na wprowadzaniu do obrotu, oddawaniu do użytku lub wykorzystywaniu systemów AI, które:

- stosują techniki podprogowe będące poza świadomością danej osoby, celowe techniki manipulacyjne lub techniki wprowadzające w błąd,

- wykorzystują słabości osoby fizycznej lub określonej grupy osób ze względu na ich wiek, niepełnosprawność, szczególną sytuację społeczną lub ekonomiczną, w celu dokonania znaczącej zmiany zachowania danej osoby lub osoby należącej do tej grupy w sposób, który wyrządza lub może z uzasadnionym prawdopodobieństwem wyrządzić u tej osoby lub u innej osoby poważną szkodę,

- służą przeprowadzeniu oceny ryzyka w odniesieniu do osób fizycznych, by ocenić lub przewidzieć prawdopodobieństwo popełnienia przez nie przestępstwa, wyłącznie na podstawie profilowania osoby fizycznej lub oceny jej cech osobowości i cech charakterystycznych (zakaz ten nie ma zastosowania do systemów AI wykorzystywanych do wspierania dokonywanej przez człowieka oceny zaangażowania danej osoby w działalność przestępczą, która to ocena opiera się na obiektywnych i weryfikowalnych faktach),

- tworzą lub rozbudowują bazy danych służące rozpoznawaniu twarzy poprzez pozyskiwanie w ramach scrapingu wizerunków twarzy z internetu lub z telewizji przemysłowej,

- są wykorzystywane do wyciągania wniosków na temat emocji osoby w miejscu pracy lub instytucjach edukacyjnych (chyba że system AI jest wdrażany lub wprowadzany do obrotu ze względów medycznych lub bezpieczeństwa),

- w oparciu o dane biometryczne kategoryzują osoby fizyczne, aby wywnioskować informacje na temat ich rasy, poglądów politycznych, przynależności do związków zawodowych, przekonań religijnych lub filozoficznych, życia seksualnego lub orientacji (zakaz ten nie jest bezwzględny).

Pełen katalog zakazanych praktyk znajduje się w art. 5 AI Actu.

Nieprzestrzeganie tych zakazów podlega administracyjnej karze pieniężnej w wysokości do 35 mln euro lub wysokości do 7% całkowitego światowego obrotu danego przedsiębiorstwa z poprzedniego roku obrotowego.

Systemy AI wysokiego ryzyka to natomiast systemy, które prawodawca unijny ocenił jako mogące mieć szkodliwy wpływ na bezpieczeństwo, zdrowie i prawa podstawowe chronione na podstawie Karty Praw Podstawowych i które z tego powodu powinny spełniać dodatkowe wymogi dotyczące nadzoru nad korzystaniem z nich. Systemy te zostały określone w art. 6 AI Actu i podzielone na dwie kategorie. Pierwszą z nich prawodawca unijny określił w art. 6 ust. 1 AI Actu, który wskazuje przesłanki uznania danego systemu AI za system wysokiego ryzyka. Druga kategoria została wyróżniona poprzez zamieszczone w art. 6 ust. 2 AI Actu odesłanie do załącznika III, który wymienia listę systemów uznanych za systemy wysokiego ryzyka. Są to m.in. systemy:

- wykorzystujące biometrię,

- przeznaczone do podejmowania decyzji o dostępie lub przyjęciu do instytucji edukacyjnych, rekrutacji, decydowania o awansach w pracy,

- przeznaczone do oceny kwalifikowalności osób fizycznych do podstawowych świadczeń i usług publicznych, oceny ich zdolności kredytowej, cen ubezpieczenia.

Na podmioty, które nie przestrzegają obowiązków ustanowionych w AI Akcie dotyczących systemów wysokiego ryzyka, może zostać nałożona administracyjna kara pieniężna w wysokości do 15 000 000 EUR lub 3% całkowitego rocznego światowego obrotu.

Obowiązki wynikające z AI Actu

AI Act nakłada na podmioty zaangażowane w tworzenie oraz używanie systemów AI różne obowiązki w zależności od ich roli w łańcuchu dostaw, a także od sposobu korzystania przez nich z AI. Podmioty takie powinny więc dokładnie zidentyfikować swoją rolę w konkretnej sytuacji wykorzystywania AI w swojej działalności. AI Act w tym zakresie wyróżnia m.in. dostawcę, importera, dystrybutora i podmiot stosujący. Podczas gdy definicje importera i dystrybutora są dość intuicyjne, kwalifikacja danego podmiotu jako dostawcy lub podmiotu stosującego niekiedy może budzić wątpliwości.

Dostawcą będzie każdy podmiot, który rozwija lub zleca rozwijanie systemu AI lub modelu AI ogólnego przeznaczenia i pod własną nazwą lub własnym znakiem towarowym wprowadza taki system AI do obrotu.

Każdy korzystający z systemu AI będzie zaś podmiotem stosującym w rozumieniu AI Actu, chyba że korzystanie z tego systemu dotyczy osobistej działalności pozazawodowej korzystającego. Jeśli zatem generujemy obrazki z użyciem systemów AI dla potrzeb prywatnych, nie musimy martwić się obowiązkami nakładanymi na podmioty korzystające

z systemów AI przez unijnego prawodawcę.

Dodatkowo należy pamiętać, że jeśli zmienimy przeznaczenie systemu AI, który został wprowadzony do obrotu i nie jest systemem AI wysokiego ryzyka, w taki sposób, że dany system AI staje się systemem AI wysokiego ryzyka, to wówczas stajemy się dostawcą systemu wysokiego ryzyka. Przykładowo zmiana może polegać na dodaniu dodatku, który pozwala systemowi AI na rozpoznawanie ludzkich emocji, przy założeniu, że to przeznaczenie nie zostało wskazane jako przeznaczenie dostarczanego systemu AI przez zewnętrznego dostawcę.

W zależności od tego, jakie funkcjonalności nadamy narzędziom wykorzystującym systemy AI, czy dojdzie do zmodyfikowania systemu AI dostarczanego przez dostawcę i czy zmiany te zmieniły przeznaczenie danego systemu, nasze obowiązki na gruncie AI Actu będą zupełnie różne.

Z uwagi na charakter tego artykułu w opisie obowiązków pominęliśmy obowiązki dotyczące modeli AI ogólnego przeznaczenia.

Obowiązki podmiotu stosującego

Jeśli stosujemy system AI wysokiego ryzyka, musimy m.in. zapewnić, że system ten jest wykorzystywany zgodnie z dołączoną do niego instrukcją obsługi, jest nadzorowany przez człowieka oraz że dane wejściowe (w zakresie, w jakim mamy nad nimi kontrolę) są adekwatne i wystarczająco reprezentatywne w odniesieniu do przeznaczenia systemu AI. Na podmiotach stosujących ciążą też obowiązki w zakresie monitoringu i zgłaszania nieprawidłowości dostawcom systemów AI wysokiego ryzyka oraz organom nadzoru, a także odpowiedniego zabezpieczenia danych dotyczących rejestrów i poinformowania pracowników oraz innych osób o wykorzystywaniu systemów AI wysokiego ryzyka w stosunku do nich (zob. w szczególności art. 26 ust. 7 i 11 AI Actu).

W przypadku systemów rozpoznawania emocji lub kategoryzacji biometrycznej podmioty stosujące mają również obowiązek poinformować osoby fizyczne, wobec których te systemy są stosowane, o fakcie ich stosowania.

Niezależnie od powyższego, jeśli system AI wykorzystywany przez podmioty stosujące:

- służy generowaniu obrazów, treści audio lub wideo stanowiących deepfake lub manipulacji takimi obrazami lub treściami,

- generuje tekst publikowany w celu informowania społeczeństwa o sprawach leżących w interesie publicznym lub manipuluje takim tekstem,

podmioty stosujące mają obowiązek ujawnić, że treści te zostały sztucznie wygenerowane lub zmanipulowane.

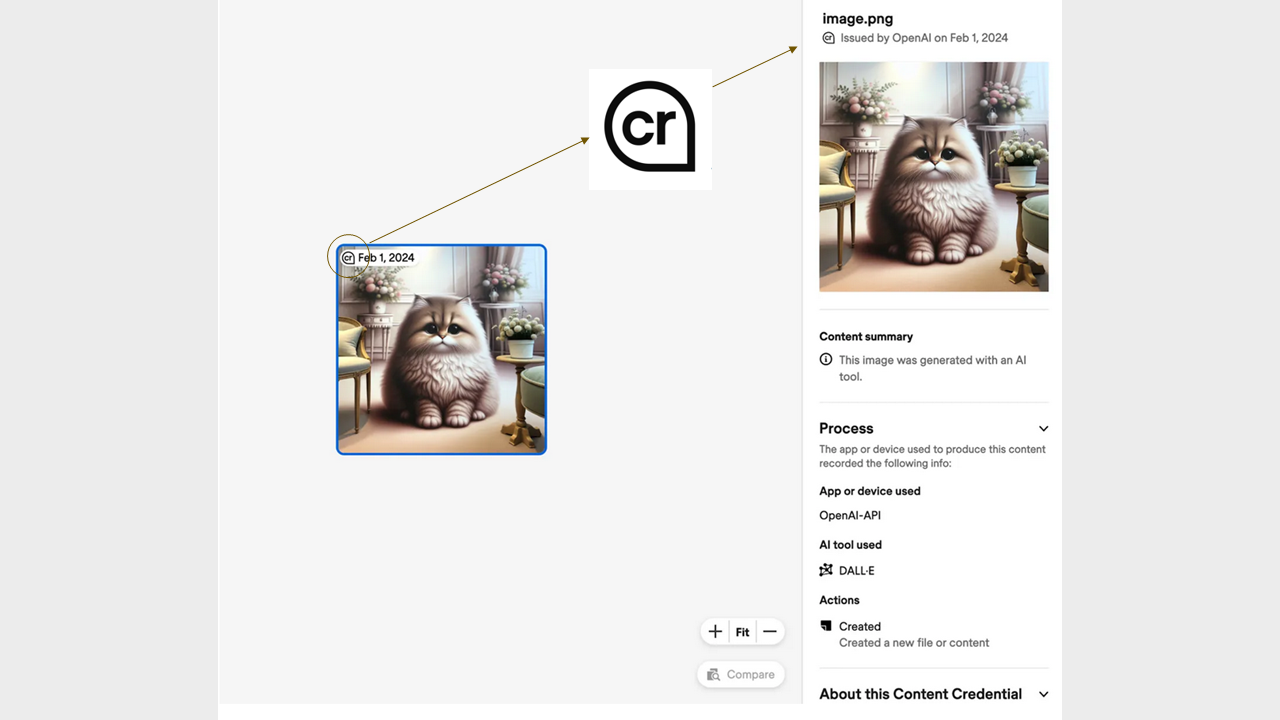

AI Act nie precyzuje, w jaki sposób podmioty stosujące mają spełnić ten obowiązek. Aktualnie stosowane na rynku oznaczenia są niejednolite. Oto kilka przykładów:

- “Who owns copyright to AI works?” prompt, ChatGPT, 13 Feb. version, OpenAI,16 Feb 2023, chat.openai.com,

- “Pointillist painting of a sheep in a sunny field of blue flowers” prompt, DALL-E, version 2, OpenAI, 8 Mar. 2023, labs.openai.com,

- “AI generated”,

- “Generated with an AI tool”,

- “AI manipulated”.

Obowiązki dostawcy

Obowiązki dostawcy systemu AI zależą od tego, czy dostarczany przez niego system jest systemem wysokiego ryzyka.

W szczególności dostawcy systemów wysokiego ryzyka zostali zobowiązani do:

- wdrożenia systemu zarządzania jakością,

- przygotowania odpowiedniej dokumentacji technicznej,

- zapewnienia nadzoru nad systemem AI ze strony człowieka,

- monitorowania systemu AI po wprowadzeniu go do obrotu i zgłaszania poważnych incydentów do organów nadzoru,

- dopełnienia formalności rejestracyjnych oraz zgodności z przepisami AI Actu,

- prowadzenia i przechowywania rejestrów zdarzeń,

- współpracy z właściwymi organami

- zarejestrowania siebie i swojego systemu w specjalnej bazie danych UE.

W przypadku systemów AI:

- przeznaczonych do wchodzenia w bezpośrednią interakcję z osobami fizycznymi,

- generujących treści w postaci syntetycznych dźwięków, obrazów, wideo lub tekstu,

dostawcy mają dodatkowo obowiązek:

- poinformować osoby fizyczne, które wchodzą w bezpośrednią interakcję z systemem AI o tym, że prowadzą interakcję z systemem sztucznej inteligencji,

- zapewnić, że wyniki systemu AI będą oznakowane w formacie nadającym się do odczytu maszynowego, i będą wykrywalne jako sztucznie wygenerowane lub zmanipulowane.

Oznacza to, że wszystkie systemy służące do generowania treści za pomocą AI od daty rozpoczęcia stosowania przepisów AI Actu, tj. od 2 sierpnia 2026 r., będą musiały posiadać funkcjonalność oznaczania, że treści przez nie generowane wygenerowano za pomocą AI. Jest jeszcze zatem moment, aby przygotować się do stosowania przepisów AI Actu i przemyśleć strategię dotyczącą korzystania z narzędzi opartych na systemach AI.

AI Act nie precyzuje jednak, w jaki sposób należy oznakować wyniki stosowania systemów AI. Praktyka rynku pokazuje, że różni dostawcy rozwiązań do tworzenia treści z pomocą AI stosują różne oznaczenia. Warto w tym kontekście zwrócić uwagę na inicjatywę Coalition for Content Provenance and Authenticity (C2PA). Koalicja, założona w 2019 r., dąży do stworzenia standardów technicznych w celu poświadczenia źródła i pochodzenia treści. Na forum koalicji zaproponowano używanie ikony CR dla oznaczania źródła pochodzenia danej grafiki.

Skrót CR pochodzi od zwrotu „Content CRedentials”. Zgodnie z założeniami po najechaniu kursorem na ikonę CR powinna otworzyć się informacja m.in. o narzędziu AI użytym do wykonania grafiki oraz inne szczegóły dotyczące jej produkcji. Niezależnie od ikony CR wielu dostawców stosuje też niewidoczne znaki wodne w metadanych pliku, w formacie rekomendowanym przez C2PA lub innym, umożliwiające odczytanie, że plik został wygenerowany z użyciem AI.

Źródło: https://www.theverge.com/2024/2/6/24063954/ai-watermarks-dalle3-openai-content-credentials

Sposób oznaczania treści oraz informowania o wchodzeniu w bezpośrednią interakcję

z osobami z systemami AI będzie prawdopodobnie uszczegółowiony w wytycznych, które powstaną w przyszłości.

Komisja Europejska już teraz promuje pakt na rzecz sztucznej inteligencji, którego celem jest zobowiązanie podmiotów będących dostawcami i stosującymi AI do dobrowolnego wdrażania postanowień AI Actu przed upływem wskazanych terminów. Pakt zachęca też do wymiany najlepszych praktyk i dostarcza praktycznych informacji na temat procesu wdrażania AI Act pomiędzy zrzeszonymi podmiotami.

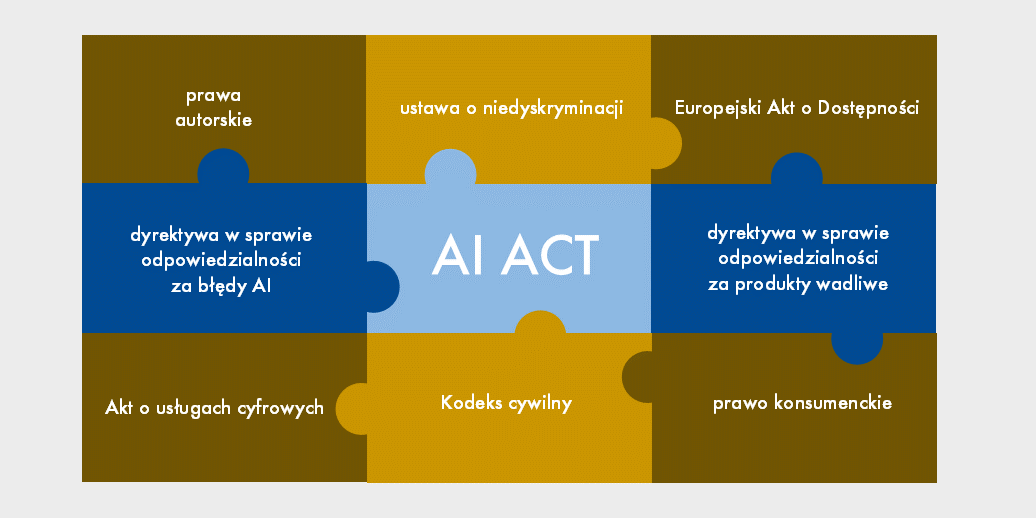

Czy to już wszystkie regulacje dotyczące tzw. sztucznej inteligencji?

Oczywiście nie. Wiele kwestii dotyczących sztucznej inteligencji uregulowanych jest w branżowych ustawach. Wybrane, istotne regulacje, które należy brać pod uwagę, wskazaliśmy poniżej.

Ewa Nagy, radca prawny, praktyka własności intelektualnej kancelarii Wardyński i Wspólnicy

[1] Pełna nazwa aktu prawnego to: rozporządzenie Parlamentu Europejskiego i Rady (UE) 2024/1689 z dnia 13 czerwca 2024 r. w sprawie ustanowienia zharmonizowanych przepisów dotyczących sztucznej inteligencji oraz zmiany rozporządzeń (WE) nr 300/2008, (UE) nr 167/2013, (UE) nr 168/2013, (UE) 2018/858, (UE) 2018/1139 i (UE) 2019/2144 oraz dyrektyw 2014/90/UE, (UE) 2016/797 i (UE) 2020/1828 (akt w sprawie sztucznej inteligencji).